WellSaid vise à faire de la parole synthétique à consonance naturelle une alternative crédible aux vrais humains.

Beaucoup de choses sont mieux dites que lues, mais la meilleure technologie vocale semble être réservée aux assistants virtuels, pas aux lecteurs d’écran ou aux livres audio générés automatiquement. WellSaid veut permettre à tout créateur d’utiliser un discours synthétique de qualité au lieu d’une voix humaine – peut-être même une version synthétique d’eux-mêmes.

Il y a eu une série d’avancées majeures dans la synthèse vocale au cours des deux dernières années alors que la technologie des réseaux neuronaux s‘améliore par rapport à l’ancienne approche hautement manuelle. Mais Google, Apple et Amazon ne semblent pas disposés à rendre leur technologie vocale disponible pour autre chose que des pépiements de votre téléphone ou de votre home hub.

A découvrir également : Le site vidéo de Baidu iQiyyi ajoute 37 millions d'abonnés en 2018 dans un contexte de pertes croissantes

Dès que j’ai entendu parler de WaveNet, et plus tard de Tacotron, j’ai essayé de contacter l’équipe de Google pour leur demander quand ils se mettraient à produire des livres audio à sonorité naturelle pour tout ce qui se trouve sur Google Books, ou dans le cadre d’AMP, ou pour en faire un service accessible, etc. Je n’ai jamais eu de nouvelles. J’ai considéré qu’il s’agissait d’une occasion manquée, car il y en a beaucoup qui ont besoin d’un tel service.

J’ai donc été heureux d’apprendre que WellSaid s’attaque à ce marché, d’une certaine façon du moins. L’entreprise est la première à lancer le programme d’incubateur de l’Allen Institute for AI (AI2) annoncé en 2017. Ils prennent leur temps !

A lire également : Rencontrez les investisseurs de GV au TechCrunch, y compris les heures de bureau du mois de mars.

L’incubateur AI2 soutenu par Allen vise à mettre en relation les startups AI avec des talents de classe mondiale.

Parlez-en, parlez !

J’ai parlé avec le PDG des cofondateurs, Matt Hocking et le directeur technique, Michael Petrochuk, qui m’ont expliqué pourquoi ils avaient décidé de créer un tout nouveau système de synthèse vocale. Le problème fondamental, disaient-ils, c’est que les systèmes existants reposent non seulement sur beaucoup d’annotations humaines pour sonner correctement, mais qu’ils ” sonnent bien ” de la même façon à chaque fois. Vous ne pouvez pas vous contenter de lui donner quelques heures d’audio en espérant qu’il saura infléchir les questions ou faire une pause entre les éléments de la liste – la plupart de ces choses doivent être expliquées pour eux. Le résultat final est cependant très efficace.

“Quand on pense à la voix humaine, ce qui rend naturel, en quelque sorte, ce sont les incohérences “, dit Hocking.

Et où trouver de meilleures incohérences que chez l’homme ? L’équipe a travaillé avec une poignée d’acteurs vocaux pour enregistrer des dizaines d’heures d’audio à transmettre au système. Il n’est pas nécessaire d’annoter le texte avec un “langage de balisage vocal” pour désigner des parties de phrases et ainsi de suite, a dit Petrochuk : “Nous avons découvert comment nous entraîner à partir de données brutes de livres audio, sans avoir à faire quoi que ce soit d’autre en plus”.

Ainsi, le modèle de WellSaid prononce souvent le même mot différemment, non pas parce qu’un modèle manuel de langage soigneusement manucuré le suggère, mais parce que la personne dont il imite l’empreinte vocale l’a fait.

Il fonctionne sur un CPU en temps réel, pas sur une grappe de GPU quelque part, donc il peut être fait hors ligne aussi bien. C’est un exploit en soi, car de nombreux algorithmes de synthèse vocale sont très gourmands en ressources.

Ce qui compte, c’est que la voix produite puisse parler n’importe quel texte d’une manière très naturelle. Voici la première partie d’un article – hélas, pas l’un des miens, qui aurait employé des circonlocutions plus mélodieuses – lu par WaveNet de Google, puis par deux des voix de WellSaid.

Les deux derniers sont nettement plus naturels que le premier. Sur certaines phrases, les voix peuvent être presque impossibles à distinguer des voix originales, mais dans la plupart des cas, je suis sûr que je pourrais choisir la voix synthétique en quelques mots.

Qu’elle soit proche, cependant, est un accomplissement. Et je peux certainement dire que si je devais faire lire un article par l’une de ces voix, ce serait celui de WellSaid. Naturellement, il peut aussi être modifié et itéré, ou des effets peuvent être appliqués pour manipuler davantage le son, comme avec toute performance vocale. Vous ne pensiez pas que les interviews que vous entendez sur NPR n’étaient pas éditées, n’est-ce pas ?

Le but est d’abord de trouver les créatifs dont le travail serait amélioré ou facilité en ajoutant cet outil à leur boîte à outils.

“Il y a beaucoup de gens qui ont ce besoin, explique Hocking, un producteur vidéo qui n’a pas les moyens d’engager un acteur de voix, quelqu’un avec un grand volume de contenu qui doit être rediffusé rapidement, si l’anglais est une langue seconde, cela ouvre beaucoup de portes, et certaines personnes n’ont pas de voix à la radio.

Ce serait bien de pouvoir ajouter de la voix en un clic plutôt que de simplement avoir du texte en bloc et de la musique libre de droits sur une annonce sociale (pensez à l’admen) :

J’ai posé des questions sur l’accueil des acteurs de la voix, à qui l’on demande bien sûr essentiellement de former leurs propres remplaçants. Ils ont dit que les acteurs étaient en fait positifs à ce sujet, pensant qu’il s’agissait d’une sorte de photographie d’archives pour la voix ; obtenez un produit pré-fabriqué pour pas cher, et si vous l’aimez, payez le créateur pour la vraie chose. Bien qu’ils ne voulaient pas s’enfermer prématurément dans de futurs modèles d’affaires, ils ont reconnu que le partage des revenus avec les acteurs de la voix était une possibilité. Le paiement des représentations virtuelles est un domaine nouveau et en pleine évolution.

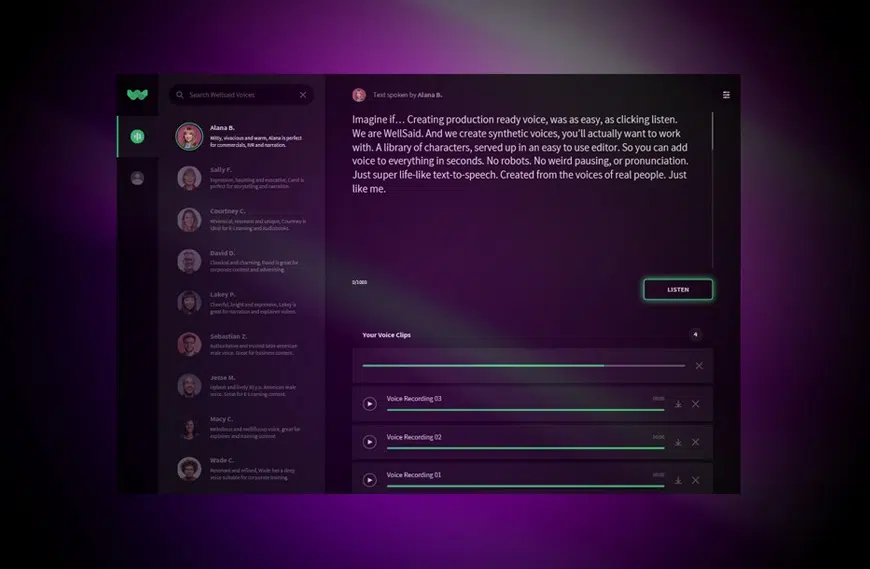

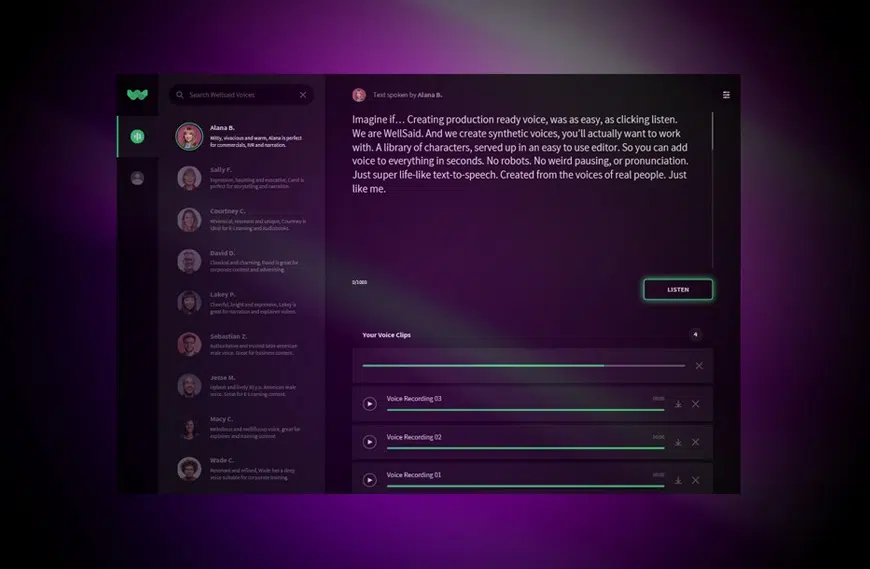

Une version bêta fermée est lancée aujourd’hui, à laquelle vous pouvez vous inscrire sur le site de l’entreprise. Ils vont se lancer avec cinq voix pour commencer, avec plus de voix et d’options à venir au fur et à mesure que la place de WellSaid sur le marché devient claire. Une partie de ce processus consistera presque certainement à inclure dans les outils utilisés par les aveugles ou les personnes handicapées, comme je l’espère depuis des années.

Ça me dit quelque chose.

Et qu’est-ce qui vient après ça ? Faire des versions synthétiques des voix des utilisateurs, bien sûr. Pas de problème ! Mais les deux fondateurs ont averti que c’est loin d’être le cas pour plusieurs raisons, même si c’est tout à fait possible.

“À l’heure actuelle, nous utilisons environ 20 heures de données par personne, mais nous entrevoyons un avenir où nous pourrons les réduire à 1 ou 2 heures tout en conservant une qualité de transmission de la voix de première qualité, a déclaré M. Petrochuk.

“Et nous pouvons construire à partir d’ensembles de données existants, comme lorsque quelqu’un a un catalogue de contenu en arrière “, a ajouté Hocking.

Le problème, c’est que le contenu n’est peut-être pas tout à fait adapté à la formation du modèle d’apprentissage approfondi, qui, tel qu’il est avancé, peut sans aucun doute être délicat. Il y a des cadrans et des boutons à ajuster, bien sûr, mais ils ont dit que le réglage fin d’une voix est plus une question d’ajouter un discours correctif, peut-être que l’acteur vocal doit lire un script spécifique qui soutient les sons ou les cadences qui ont besoin d’un coup de pouce.

Ils l’ont comparé à la mise en scène d’un tel acteur plutôt qu’à l’ajustement du code. Après tout, on ne dit pas à un acteur d’augmenter les pauses après les virgules de 8 % ou de 15 millisecondes, selon la durée la plus longue. C’est plus efficace de leur montrer : “Dis-le comme ça.”

Malgré tout, obtenir la bonne qualité avec des données de formation limitées et imparfaites est un défi qui nécessitera un travail sérieux si et quand l’équipe décide de l’entreprendre.

Mais comme certains d’entre vous l’ont peut-être remarqué, il y a aussi des parallèles avec le monde peu recommandable des “deepfakes” : téléchargez une douzaine de podcasts ou de discours et vous avez assez de matériel pour faire une réplique passable de la voix d’une personne, peut-être une personnalité publique. Ceci a bien sûr une synergie inquiétante avec la capacité existante de simuler la vidéo et d’autres images.

Ce n’est pas nouveau pour Hocking et Petrochuk. Si vous travaillez en IA, ce genre de chose est inévitable.

“Nous venons d’AI2, où la devise est ” l’intelligence artificielle pour le bien commun “, ce à quoi nous souscrivons vraiment et qui nous différencie de nos concurrents qui faisaient les voix de Barack Obama avant même d’avoir un MVP (produit minimum viable). Nous allons surveiller de près pour nous assurer qu’il n’y a pas d’utilisation négative, et nous n’allons pas nous lancer avec la possibilité de faire une voix personnalisée, parce que cela permettrait à n’importe qui de créer une voix à partir de n’importe qui”.

La surveillance active est à peu près tout ce à quoi on peut s’attendre d’une personne ayant une technologie d’IA potentiellement troublante – bien qu’elle étudie des techniques d’atténuation qui pourraient aider à identifier les voix synthétiques.

Avec l’accent mis sur la présentation multimédia du contenu et de la publicité plutôt que sur l’écriture, WellSaid semble prêt à jouer un rôle précoce dans un marché en pleine croissance. Au fur et à mesure que le produit évolue et s’améliore, il est facile de l’imaginer se déplacer dans de nouveaux espaces plus restreints, comme les applications à décalage temporel (podcast instantané à 5 voix au choix !) et même reprendre le territoire actuellement réclamé par les assistants vocaux. Ça m’a l’air bien.